Ngày 6/8/2025, Nvidia chính thức công bố hợp tác với OpenAI, mở ra bước ngoặt lớn cho giới công nghệ: chạy các mô hình ngôn ngữ lớn (LLM) ngay tại nhà mà không cần kết nối Internet hay đăng ký thuê bao đám mây.

AI offline với sức mạnh từ card RTX 16GB

Với người dùng sở hữu card đồ họa Nvidia GeForce RTX 16GB trở lên, đặc biệt là RTX 4080 và 5090, bạn hoàn toàn có thể xử lý các mô hình GPT-OSS-20B trên máy cá nhân, mang đến hiệu suất xử lý ấn tượng — lên tới 256 token/giây. Đây là bước tiến lớn cho AI offline trên PC, giúp tiết kiệm chi phí và tăng cường bảo mật dữ liệu cá nhân.

Không chỉ dành cho chuyên gia

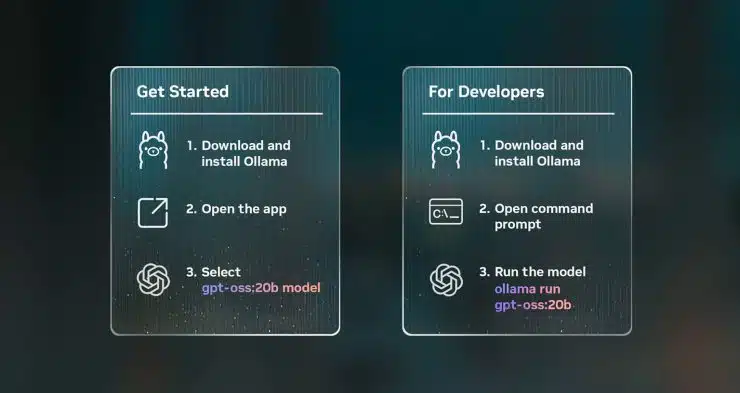

Chạy AI tại nhà không còn là đặc quyền của giới lập trình viên. Nvidia và OpenAI đã tối ưu hóa hệ thống để cả người dùng phổ thông cũng dễ dàng tiếp cận. Thông qua các template có sẵn, bạn chỉ cần chọn mẫu, upload tệp PDF hoặc nhập lệnh – AI sẽ xử lý tức thì.

Giải pháp cho doanh nghiệp và máy chủ

Với các doanh nghiệp, mô hình GPT-OSS-120B là lựa chọn mạnh mẽ, yêu cầu GPU tối thiểu 80GB VRAM, như dòng Nvidia Blackwell. Trên các hệ thống như GB200 NVL72, mô hình có thể xử lý 1,5 triệu token/giây, phục vụ đồng thời hàng chục nghìn người dùng.

Công cụ hỗ trợ phát triển mạnh mẽ

Đối với lập trình viên, Microsoft AI Foundry Local là giải pháp tích hợp mạnh mẽ, tận dụng ONNX Runtime, CUDA, TensorRT, hỗ trợ dòng lệnh, SDK và mở rộng dễ dàng. Ngoài ra, Nvidia còn cộng tác với cộng đồng mã nguồn mở(như llama.cpp) để cung cấp các tối ưu hóa nâng cao như Flash Attention, CUDA Graphs, và định dạng mới MBFP4.

AI trên PC – Giấc mơ thành hiện thực

Sự kết hợp giữa Nvidia và OpenAI đang biến "giấc mơ AI tại nhà" thành hiện thực. Dù bạn là người dùng phổ thông, lập trình viên, hay doanh nghiệp – nay đã có thể trải nghiệm AI mạnh mẽ, bảo mật và không phụ thuộc đám mây, ngay trên hệ thống của mình.